A Disney Research acabou de publicar um paper sobre dar vida ao Olaf (sim, o boneco de neve falante de Frozen) como um robô físico que anda. Antes de revirar os olhos achando que é mais uma demo de “entretenimento com IA”, segura aí: isso é engenharia interessante resolvendo problemas reais que a maioria dos roboticistas simplesmente ignora.

O Problema Que Ninguém Comenta

A real sobre robôs bípedes é a seguinte: ficamos muito bons em fazer robôs que escalam montanhas, dão mortal para trás e se recuperam de chutes. A Boston Dynamics provou isso faz mais de dez anos. Mas ainda somos péssimos em fazer robôs que pareçam e se movam como personagens com os quais as pessoas se importam de verdade.

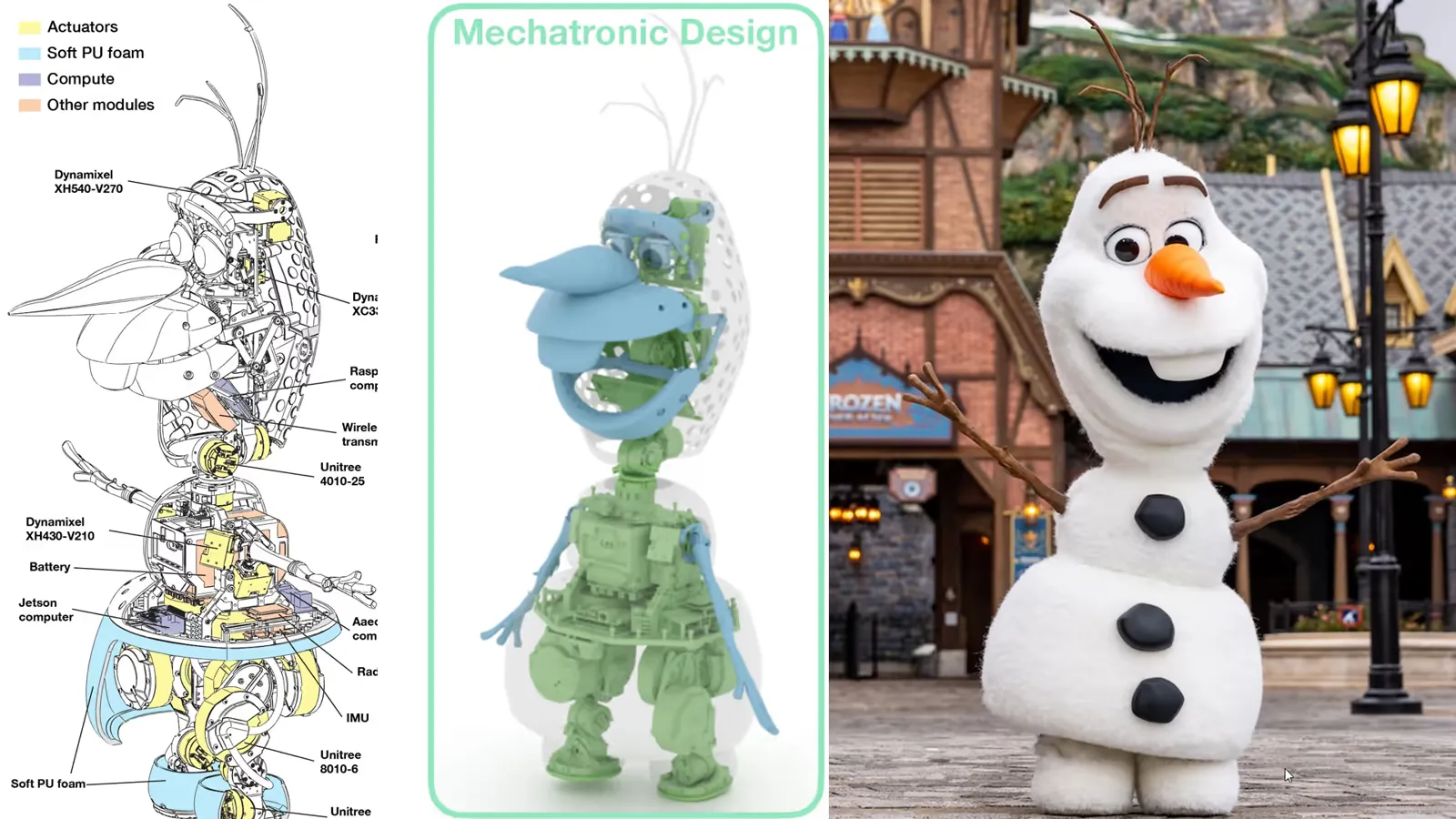

O Olaf não foi feito como o Atlas ou o Spot. Ele tem:

- Uma cabeça enorme (proporcionalmente ao corpo)

- Pés minúsculos em forma de bola de neve, sem pernas visíveis

- Um pescoço fino que precisa sustentar essa cabeça absurda

- Braços “flutuando” nas laterais, sem estrutura de ombro

- Um estilo de movimento propositalmente cartunesco e não físico

Tenta encaixar isso num robô bípedo tradicional. Não dá. As proporções estão erradas, o espaço de trabalho é inviável e as restrições estéticas impedem você de simplesmente enfiar atuadores onde der.

A Estranheza Mecânica

A solução do time da Disney envolve um design mecânico genuinamente inteligente, do tipo que não aparece todo dia.

Pernas Assimétricas Escondidas Sob a “Saia”

As pernas do Olaf ficam completamente escondidas dentro da bola de neve inferior. O truque é este: as duas pernas são assimétricas.

- Perna esquerda: rotação de quadril para trás, joelho para frente

- Perna direita: rotação de quadril para frente, joelho para trás

Por quê? Porque pernas simétricas bateriam uma na outra dentro de um volume apertado. Ao inverter uma delas, eles maximizam o espaço de movimento mantendo tudo escondido sob uma “saia” de espuma macia que se deforma quando o robô dá passos de recuperação.

Bônus importante: as duas pernas usam peças idênticas, só espelhadas. Menos componentes únicos para fabricar e manter.

Linkagens Esféricas nos Ombros

Não existe espaço para colocar atuadores nos ombros do Olaf (ele basicamente não tem ombros). Então eles colocaram os atuadores no tronco e movimentaram os braços remotamente usando linkagens esféricas de 5 barras.

Eu precisei pesquisar isso. É um acoplamento mecânico que converte rotação de atuadores enterrados no corpo em movimento de braço com 2 graus de liberdade. O mesmo princípio aparece na mandíbula (linkagem de 4 barras) e nos olhos (outro sistema de 4 barras para inclinação e pálpebras).

Acionamento remoto por linkagens não é novidade, mas fazer isso de forma limpa num personagem com fantasia é complicado. Você briga com tensão do tecido, rugas e o fato de que a roupa esconde toda a geometria do mecanismo.

O Problema de Controle: Quando Seu Robô Superaquece

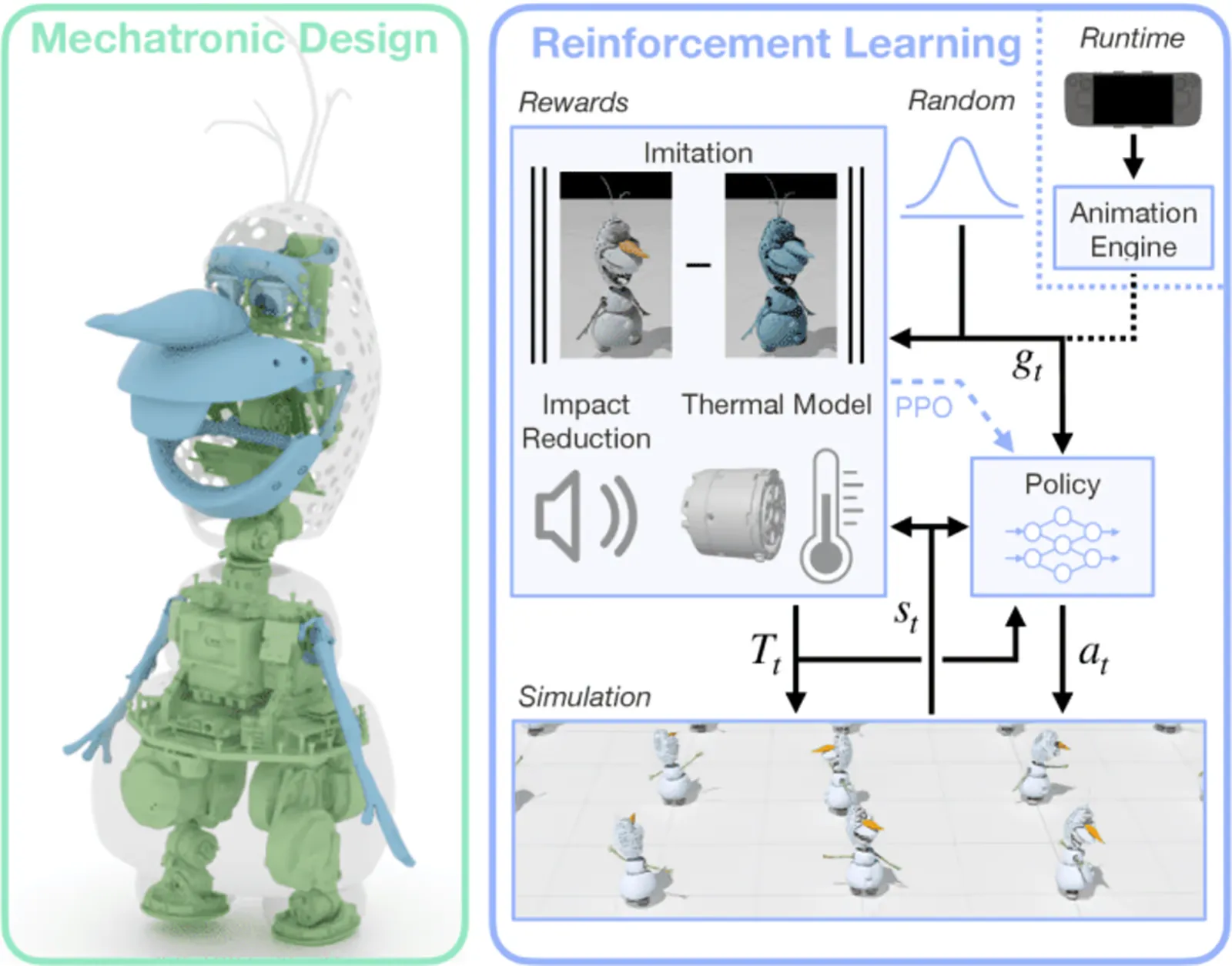

Aqui a coisa fica realmente interessante do ponto de vista de machine learning. Eles usam Reinforcement Learning com recompensas por imitação. A política aprende a seguir animações de referência enquanto mantém equilíbrio. Nada fora do padrão se você já leu papers no estilo DeepMimic.

Só que o Olaf tem um problema que robôs tradicionais não costumam ter: os atuadores do pescoço superaquece.

Por quê?

- A cabeça é pesada

- O pescoço é fino (por estética)

- Atuadores pequenos = menos capacidade térmica

- A fantasia retém calor

Nos testes iniciais, alguns movimentos de cabeça faziam os atuadores baterem 100 °C em 40 segundos. Isso não é bug de software. É a física cobrando a conta.

Políticas Sensíveis à Temperatura (Finalmente Algo Útil)

A maioria dos papers de reinforcement learning ignora temperatura de atuador. O time da Disney modelou isso explicitamente:

A variação de temperatura vem do aquecimento por efeito Joule (proporcional ao torque ao quadrado) e do resfriamento para o ambiente. Eles ajustaram e usando dados reais: 20 minutos medindo temperatura e torque, depois regressão por mínimos quadrados.

Em seguida, adicionaram a temperatura como entrada da política e incluíram uma recompensa baseada em Control Barrier Function (CBF) que penaliza a política quando ela caminha em direção ao limite térmico:

Tradução: se você está perto do limite de temperatura, a derivada da temperatura tem que ser negativa ou zero. A política aprende a reduzir torque de forma proativa antes de fritar o hardware.

Na prática, o Olaf relaxa levemente o rastreamento da cabeça quando fica muito tempo olhando para cima, inclinando de volta para uma posição mais neutra. O erro de rastreamento aumenta só alguns graus, mas o aquecimento cai drasticamente. Ele não superaquece, e ninguém percebe.

Isso não é gambiarra. É controle com restrições bem feito. Deveria ser padrão.

O Problema do Barulho

Um detalhe que quase toda demo ignora: o som dos passos importa quando você quer vender a ilusão de um personagem vivo.

Passadas pesadas destroem a magia. O Olaf deveria parecer leve e saltitante, não uma máquina de 15 kg batendo no chão.

Eles adicionaram uma recompensa de redução de impacto que penaliza grandes variações de velocidade vertical no contato do pé com o solo:

O evita que a recompensa exploda durante a resolução de contato da simulação, onde motores físicos podem gerar picos absurdos de velocidade e bagunçar o treinamento.

Resultado: redução média de 13,5 dB no nível sonoro em uma caminhada de 5 minutos. Dá para ouvir no vídeo. O antes e depois é bem claro. A política aprende a pousar o pé com cuidado sem sacrificar o movimento.

O Detalhe do Andar Calcanhar–Ponta

Mais uma: o ciclo de caminhada do Olaf usa movimento de calcanhar para ponta do pé. A maioria dos robôs bípedes ignora isso porque contato com o pé inteiro é mais estável. Mas é esse detalhe que faz a caminhada parecer humana (e, no caso, “Olafiana”).

Eles treinaram uma política sem esse movimento como ablação. Citação direta do paper: “o movimento resultante parece mais robótico”. Dá para ver no vídeo suplementar. É sutil, mas faz diferença.

Esse é o tipo de detalhe que separa “robô que funciona” de “personagem convincente”. E ainda por cima complica o controle, porque calcanhar–ponta dificulta o equilíbrio.

Detalhes de Implementação Que Importam

Treinamento:

- PPO (Proximal Policy Optimization) no Isaac Sim

- 8192 ambientes paralelos numa única RTX 4090

- 100k iterações (cerca de 2 dias de treino)

- Políticas rodando a 50 Hz no robô, interpoladas para 600 Hz nos atuadores

A política recebe comandos de alto nível (alvos do pescoço, velocidade de trajetória etc.) vindos de um Animation Engine. Esse motor:

- Reproduz animações ociosas em loop (movimento dos olhos, braços sutis)

- Dispara clipes curtos (gestos, falas)

- Mapeia joystick para controle em tempo real durante puppeteering

A arquitetura em tempo de execução vem de um paper anterior da Disney Research sobre controle de personagens bípedes. Nada de reinventar a roda.

Por Que Isso Importa Além do Entretenimento

Isso não é “o futuro da robótica”. É pesquisa para parques temáticos. Mas as técnicas são reaproveitáveis.

Controle Sensível à Temperatura

Qualquer robô com alto torque em pouco espaço (humanoides, braços manipuladores compactos) vai bater em limites térmicos. Modelar temperatura explicitamente e colocar isso na política é muito melhor do que só estourar limite de corrente.

Objetivos Acústicos

Robôs de serviço em casas, hospitais e armazéns precisam ser silenciosos. Moldar recompensas para reduzir impacto é barato e funciona.

Designs Assimétricos

Somos obcecados por simetria porque biologia é assim. Mas em volumes restritos (exoesqueletos, plataformas compactas), cinemática assimétrica pode ser exatamente o que você precisa.

Atuação Remota com Linkagens

Quando não dá para colocar atuadores direto nas juntas (espaço, peso, estética), linkagens bem projetadas resolvem. Dá mais trabalho, mas pode valer a pena.

A Parte da Honestidade Brutal™

Esse robô não é robusto. Não vai escalar trilha nem aguentar perturbação adversarial. Foi otimizado para ambientes controlados, com chão plano e sem ninguém tentando derrubá-lo.

As pernas assimétricas aumentam a complexidade. São duas orientações diferentes, mais modos de falha e manutenção mais chata.

O modelo térmico é de primeira ordem e ignora atrito mecânico e aquecimento do invólucro ao longo de horas. Funciona para demos curtas, mas não para turnos de 8 horas sem pausa.

A recompensa de impacto reduz o barulho, mas não elimina. Só deixa menos irritante.

O Que Eles Acertaram

Apesar disso, isso é boa engenharia, porque:

- Eles entregaram. O robô anda no mundo real. Não é só simulação.

- Respeitaram as restrições. Abraçaram o design do personagem em vez de lutar contra ele.

- Mediram o que importa. Temperatura, ruído, erro de rastreamento. Tudo quantificado.

- Abriram o jogo. O paper tem detalhes suficientes para replicar as ideias (CBF térmico, recompensas de impacto, pernas assimétricas).

- Evitaram hype. Não vendem isso como AGI nem robótica geral. É sobre fazer o Olaf andar bem, sem superaquecer e sem parecer uma britadeira.

Considerações Finais

A robótica de pernas passou décadas perseguindo desempenho funcional: velocidade, eficiência, robustez. Isso gerou máquinas impressionantes, mas que parecem… máquinas.

O projeto do Olaf inverte a prioridade: fidelidade ao personagem primeiro, função depois. E isso expôs problemas diferentes, que forçaram soluções novas.

É o futuro? Não. Mas lembra que objetivos diferentes revelam problemas diferentes, e resolver esses problemas gera técnicas que o resto da comunidade pode roubar sem culpa.

Além disso, é um boneco de neve robô que anda e não derrete. Isso já é incrível.

Paper (arXiv): Olaf: Bringing an Animated Character to Life in the Physical World